09. 在 PyTorch 中定义网络

06 定义网络 V1

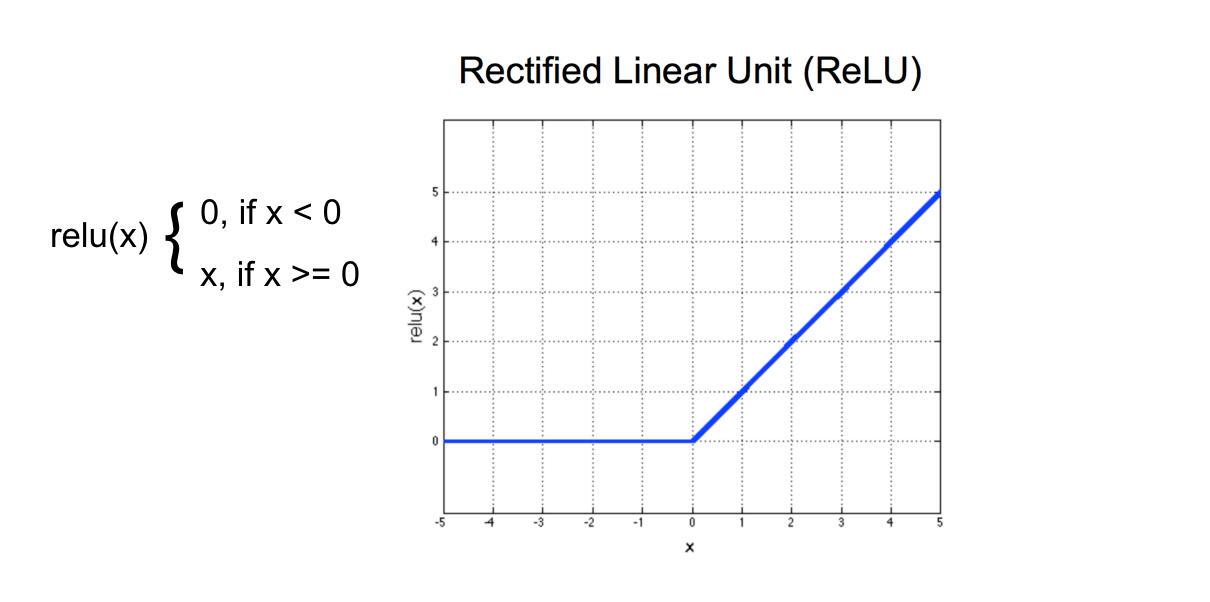

ReLU 激活函数

激活函数的作用是缩放某个层的输出,使它们变成连续的很小值。和标准化输入值类似,这一步能提高模型训练效率!

ReLU 激活函数是“修正线性单元”的简称,也是最常用的隐藏层激活函数之一,表示输入 x 对应的正数。对于具有任何负像素值的输入图像,它会将所有这些值变成 0(黑色)。这种技巧会将值控制在 0以上,即下限是 0。

ReLU 函数

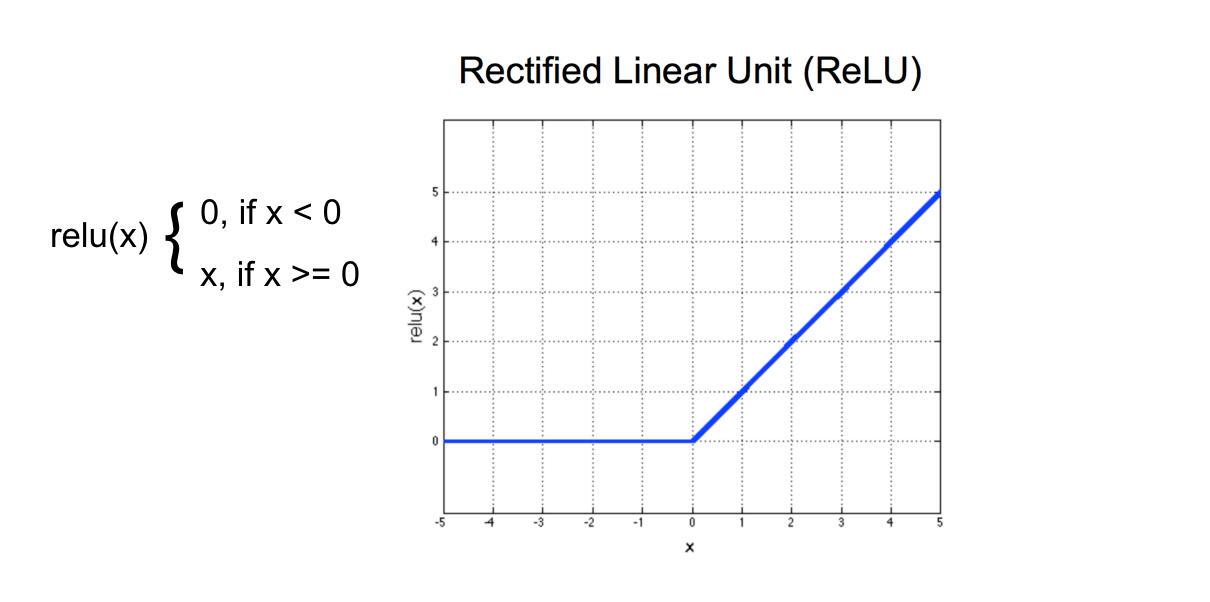

06 定义网络 V1

激活函数的作用是缩放某个层的输出,使它们变成连续的很小值。和标准化输入值类似,这一步能提高模型训练效率!

ReLU 激活函数是“修正线性单元”的简称,也是最常用的隐藏层激活函数之一,表示输入 x 对应的正数。对于具有任何负像素值的输入图像,它会将所有这些值变成 0(黑色)。这种技巧会将值控制在 0以上,即下限是 0。

ReLU 函数